2024年以来,随着国内外多家厂商不断推出新模型,大语言模型API定价持续下调,价格战愈演愈烈。作为一名普通用户,更低的价格意味着更多的尝试。但大部分的用户并不会通过API使用模型。貌似个人用户使用API大部分是为了整花活。 正好手里还有一台的云服务器,用来搭建一个聊天机器人刚好合适。

先决条件

要完成本教程,您需要:

了解docker和docker-compose的基本用法

确保2G及以上的运行内存

有一个闲置的qq账号

本教程采用容器化部署并推荐使用此方式

配置Langbot

克隆仓库

1

2

| git clone https://github.com/langbot-app/LangBot

cd LangBot

|

编辑docker-compose.yaml

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

| version: "3"

services:

langbot:

image: docker.langbot.app/langbot-public/rockchin/langbot:latest

container_name: langbot

volumes:

- ./data:/app/data

- ./plugins:/app/plugins

restart: on-failure

environment:

- TZ=Asia/Shanghai

ports:

- 5300:5300

- 2280-2290:2280-2290

networks:

- langbot-network

networks:

langbot-network:

external: true

|

启动容器

可以访问5300端口查看WebUI

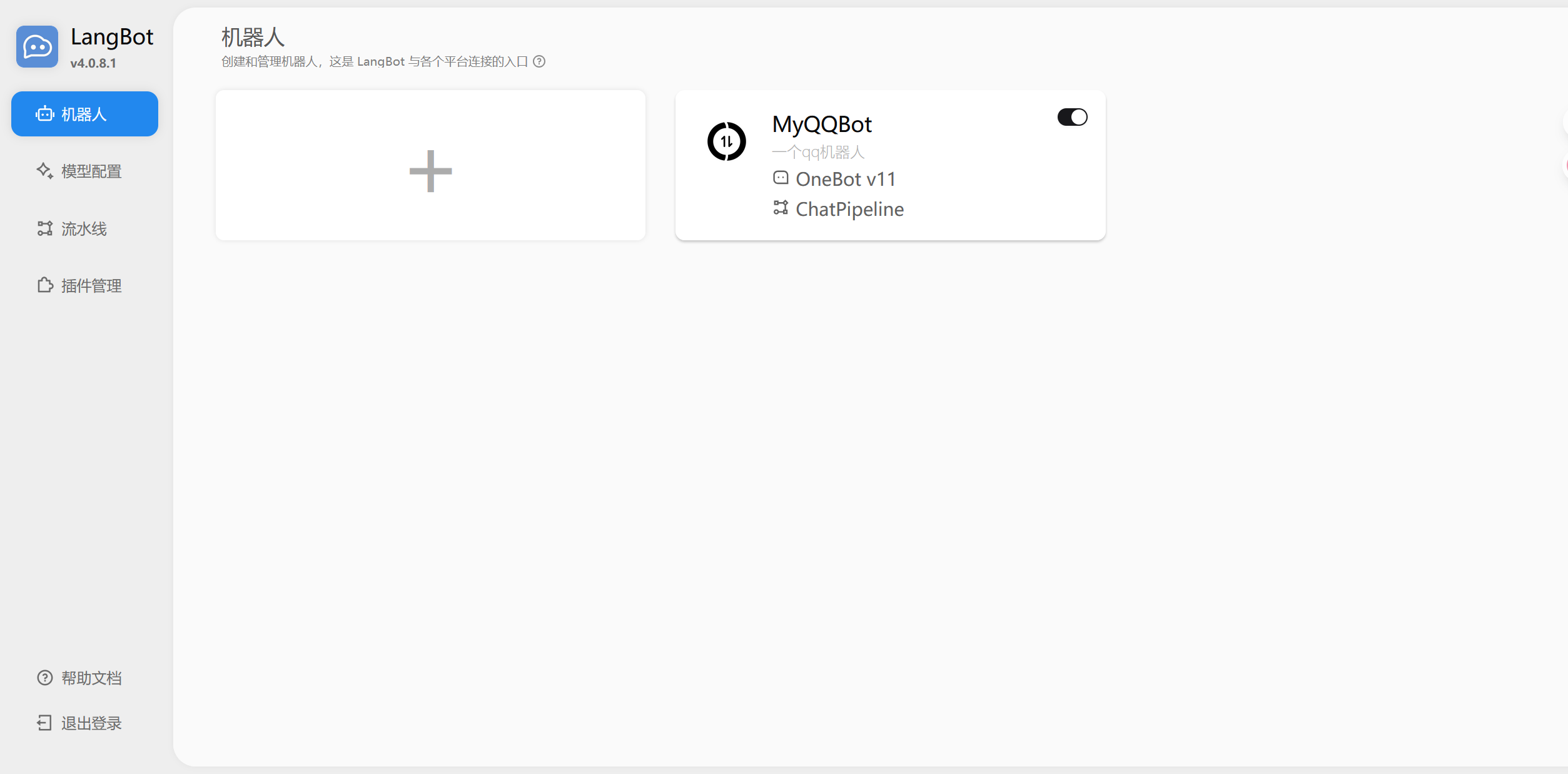

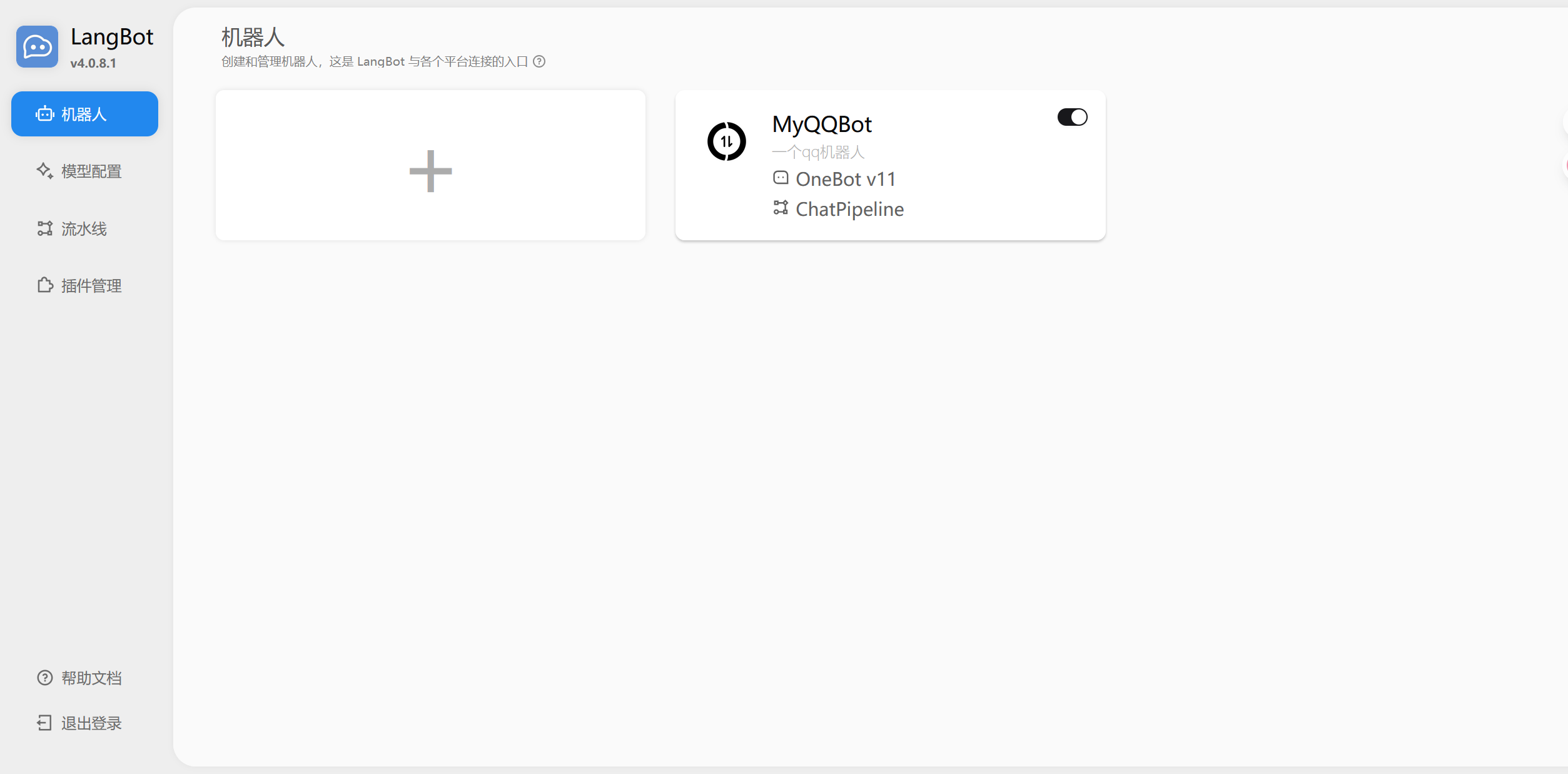

点击机器人配置界面中的加号创建机器人,输入机器人的名称,平台适配器选择OneBot,其他保持默认即可

切换到模型配置页面,点击加号添加模型API。这里以硅基流动的DeepSeek-V3模型为例,模型名称务必要和供应商一致,填写自己申请的API Key,并添加额外参数,测试成功后保存。

配置Napcat

创建docker-compose.yaml

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

|

version: "3"

services:

napcat:

environment:

- NAPCAT_UID=${NAPCAT_UID}

- NAPCAT_GID=${NAPCAT_GID}

ports:

- 3000:3000

- 3001:3001

- 6099:6099

volumes:

- ./.config/QQ:/app/.config/QQ

- ./napcat/config:/app/napcat/config

container_name: napcat

restart: always

image: docker.1ms.run/mlikiowa/napcat-docker

networks:

- langbot-network

networks:

langbot-network:

external: true

|

启动容器

访问6099端口访问WebUI,扫码登录QQ,选择网络配置,新建Websocket客户端并启用。

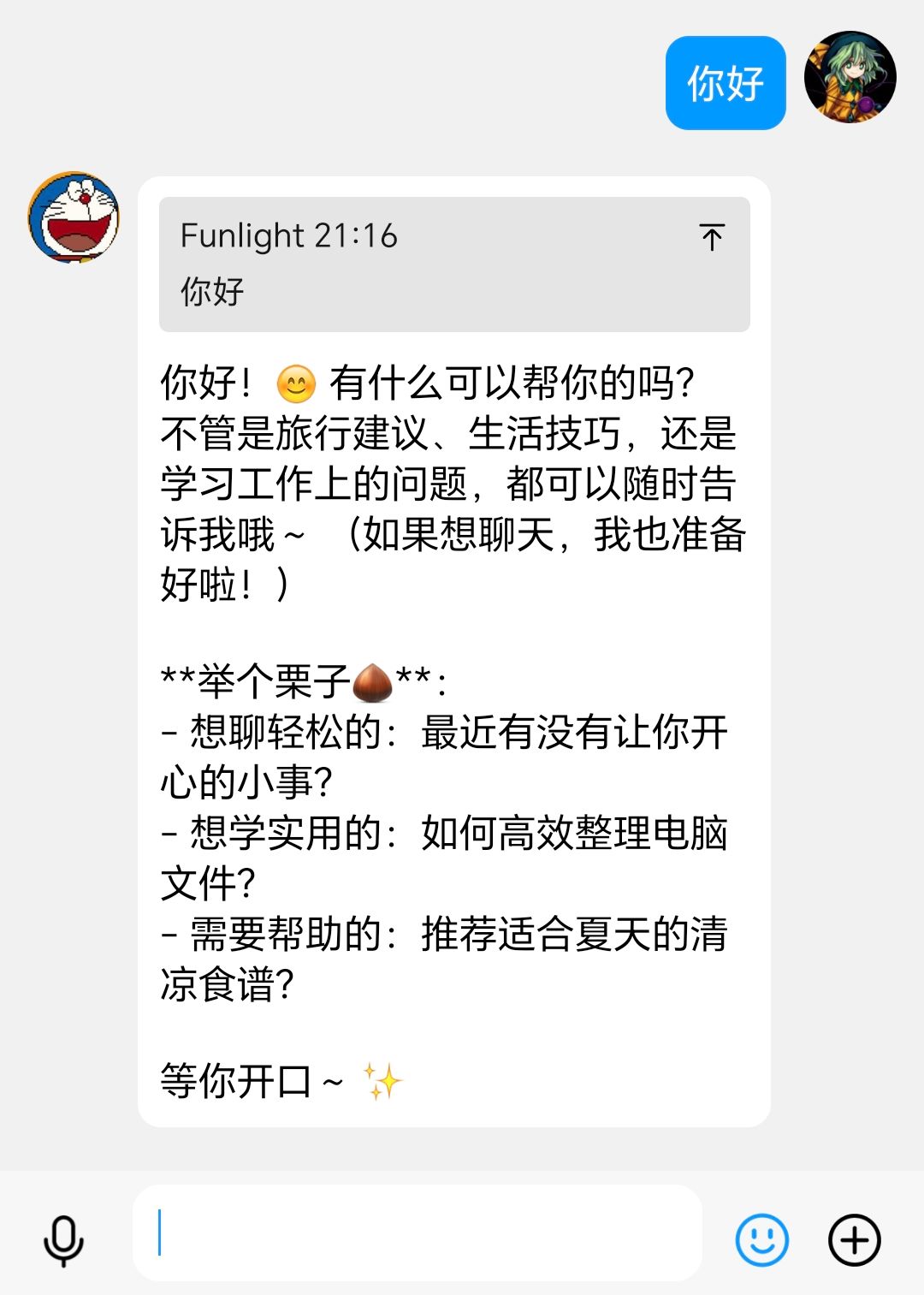

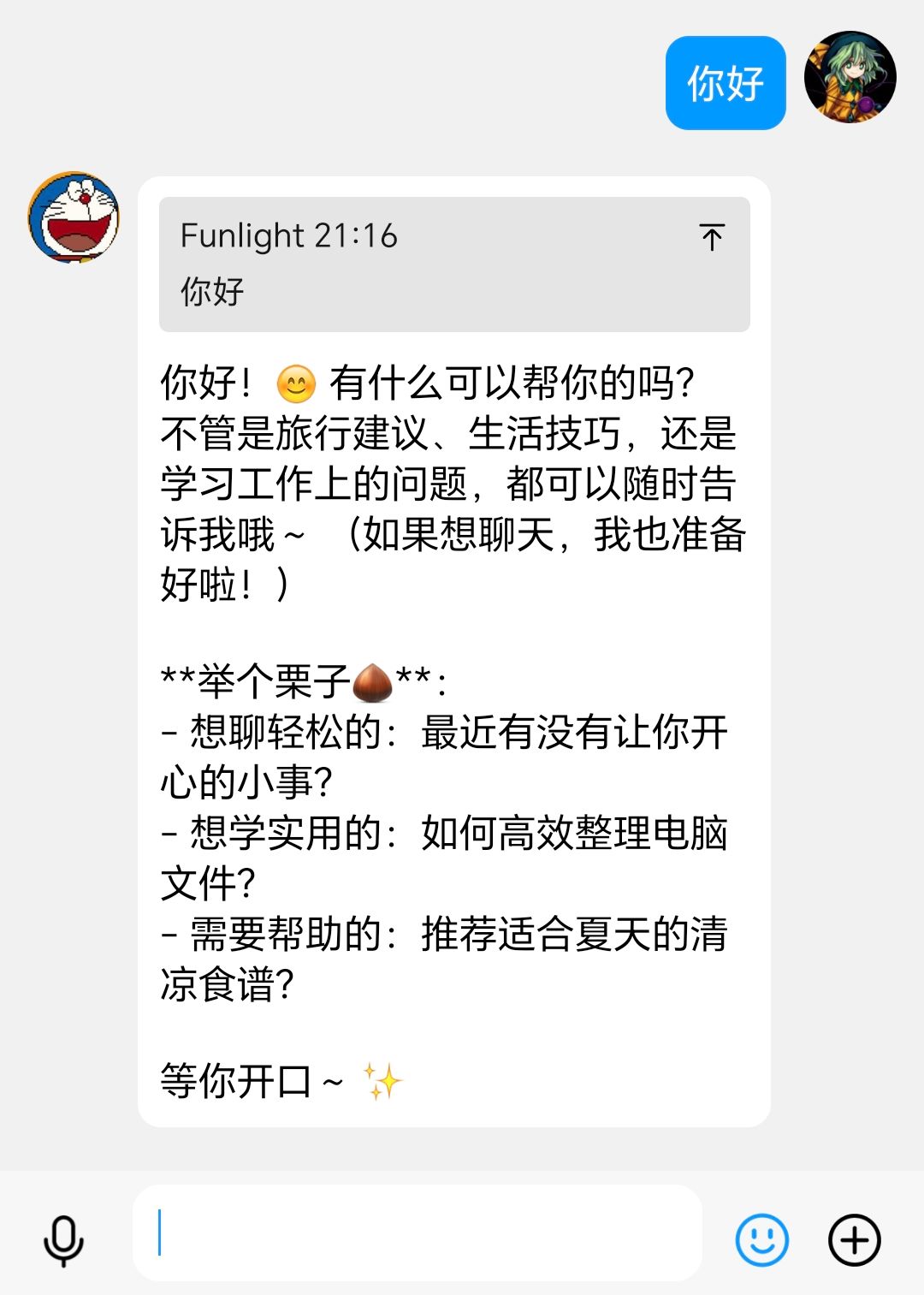

对话效果: